Hallo liebe Forengemeinde,

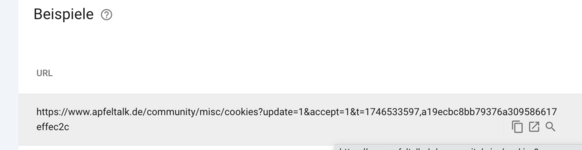

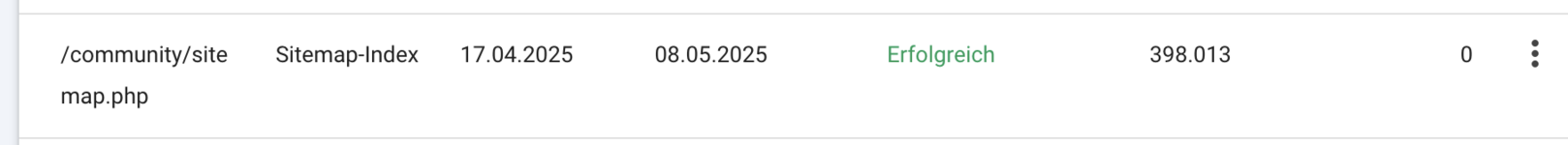

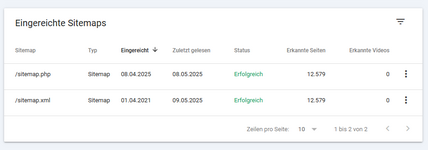

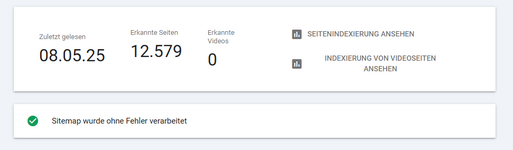

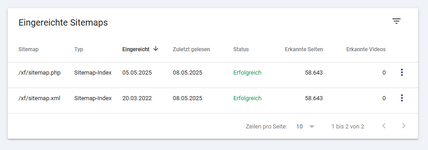

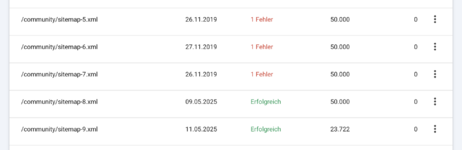

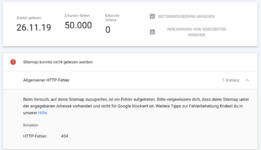

in unserem Forum Apfeltalk suchen wir aktuell nach Ursachen dafür, dass seit geraumer Zeit unsere Foren-Sitemaps (Verzeichnis "community") nicht mehr sauber von Google gelesen werden. Die regelmäßige Generierung der Sitemaps via cronjob funktioniert, die Dateien werden auch erzeugt und abgelegt.

Unsere robots.txt sieht seit Ewigkeiten so aus:

Die generierten Sitemaps sehen, wenn man sie live via sitemap.php anschaut, auch sauber aus. Dennoch möchte Google sie nicht indexieren.

Wir fragen uns nun, ob eine Umstellung auf .xml Veränderungen/Verbesserungen mit sich brächten und wie dann die syntax der Datei aussehen müsste. So sieht sie ja auf dem Server aktuell aus:

Oder gibt es einen anderen Bug auf unserer Seite, den wir bisher übersehen? Für Eure Unterstützung wären wir sehr dankbar!

Viele Grüße,

Sylvia

in unserem Forum Apfeltalk suchen wir aktuell nach Ursachen dafür, dass seit geraumer Zeit unsere Foren-Sitemaps (Verzeichnis "community") nicht mehr sauber von Google gelesen werden. Die regelmäßige Generierung der Sitemaps via cronjob funktioniert, die Dateien werden auch erzeugt und abgelegt.

Unsere robots.txt sieht seit Ewigkeiten so aus:

Code:

User-agent: *

Disallow: /magazin/author/

Disallow: /redaktion/

Disallow: /go/

Disallow: /misc/cookies/

#Disallow: /community/forums/magazin.263

User-agent: WebReaper

User-agent: WebCopier

User-agent: Offline Explorer

User-agent: HTTrack

User-agent: Microsoft.URL.Control

User-agent: EmailCollector

User-agent: penthesilea

Sitemap: https://www.apfeltalk.de/community/sitemap.phpDie generierten Sitemaps sehen, wenn man sie live via sitemap.php anschaut, auch sauber aus. Dennoch möchte Google sie nicht indexieren.

Wir fragen uns nun, ob eine Umstellung auf .xml Veränderungen/Verbesserungen mit sich brächten und wie dann die syntax der Datei aussehen müsste. So sieht sie ja auf dem Server aktuell aus:

Code:

<?php

use XF\Pub\App;

use XF\Sitemap\Renderer;

$dir = __DIR__;

require $dir . '/src/XF.php';

\XF::start($dir);

$app = \XF::setupApp(App::class);

/** @var Renderer $renderer */

$renderer = $app['sitemap.renderer'];

$request = $app->request();

$response = $app->response();

$counter = $request->filter('c', 'uint');

$response = $renderer->outputSitemap($response, $counter);

$response->send($request);Oder gibt es einen anderen Bug auf unserer Seite, den wir bisher übersehen? Für Eure Unterstützung wären wir sehr dankbar!

Viele Grüße,

Sylvia